Big Foot : le big data pensé pour les usagers

Arrivé à terme en octobre 2015, le projet FP7 Big Foot a été salué par le comité d’experts en charge de sa revue finale. Il est le fruit de trois années de recherche d’un consortium académique et industriel européen mené par Eurecom. Big Foot propose un service cloud de traitement des big data et de gestion de leurs espaces de stockage, au travers d’une interface simple et prenant en compte les usages des analystes et des gestionnaires de services. Pietro Michiardi, chercheur à Eurecom en sciences informatiques et instigateur du projet Big Foot nous éclaire sur la nouveauté offerte par ce logiciel web.

Comment définiriez-vous Big Foot ?

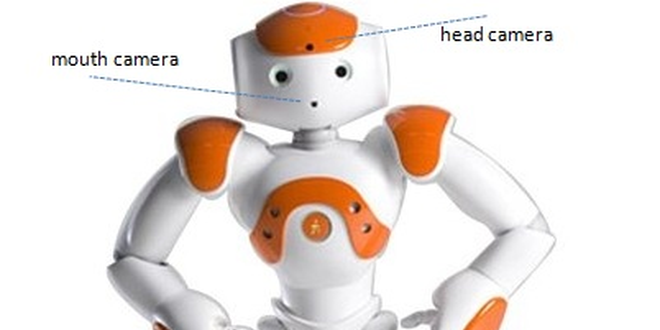

Pietro Michiardi : Big Foot est une plateforme cloud. C’est un ensemble d’outils qui permet le stockage et l’analyse de données massives : les big data. La composante novatrice est que ce service est adapté à la demande. Pour l’utilisateur, l’interface de l’application web est très simple : il peut voir où sont stockées les données et les télécharger en un clic. La mise en place du cluster de calcul, l’exécution et la présentation des résultats sont transparents.

Il est très important de préciser que ce service est conçu pour un cloud privé, et non public. C’est à dire que l’acteur qui gère la plateforme est aussi celui qui détient les données. Cela amène une caractéristique principale de Big Foot : il n’y a pas besoin de charger la base de données brute dans une base traditionnelle, les calculs peuvent être directement lancés sur les données brutes. C’est possible grâce à nos travaux de recherche et le développement de DINoDB, un logiciel qui nous permet de formuler les analyses avec le système de requête informatique traditionnel — le SQL — mais avec un moteur complètement différent.

Big Foot offre une alternative à l’augmentation croissante des infrastructures au sein des entreprises. Crédits : Eurecom, GridPocket.

À qui est destiné ce système d’exploitation pour applications big data ?

PM : Il est destiné à deux types d’acteurs différents. Premièrement ceux qui sont aujourd’hui appelés les data scientists et dont le rôle est d’analyser les grandes bases de données pour en tirer des informations pertinentes ou développer des modèles de machine learning. Mais Big Foot s’adresse aussi aux gestionnaires d’infrastructures des systèmes d’information, qui cherchent à offrir de nouveaux modèles big data à leurs data scientists.

L’enjeu avec Big Foot est de séparer ces utilisations faites par les différents acteurs. Les data scientists ne sont pas forcément intéressés par l’établissement et la configuration de clusters de calcul, et les gestionnaires ne savent pas forcément ce qu’est le machine learning. Ces deux rôles sont reconnus par Big Foot, et le déploiement du service ne pose pas de conflit.

Aucune autre plateforme n’intégrait cette considération des usages ?

PM : Non, et c’est ce qui a motivé le lancement de ce projet. En 2009, j’ai commencé à vouloir étendre mon domaine de recherche dans les systèmes distribués et l’algorithmique. Après plusieurs essais, la vision consolidée de Big Foot est arrivée en 2011. J’ai alors contacté un réseau mixte entre chercheurs et industriels pour consolider un consortium autour d’Eurecom, pilote du projet, et qui a une empreinte très forte en algorithmique. C’est ainsi que nous ont rejoints l’université technique de Berlin (TU Berlin), l’école polytechnique fédérale de Lausanne (EPFL), Symantec et une jeune start-up : GridPocket.

Big Foot peut être déployé automatiquement par intégration dans un environnement Openstack. Crédits : Eurecom, GridPocket.

Quels ont été les rôles des partenaires académiques dans le développement du projet Big Foot ?

PM : Les chercheurs du groupe database de l’EPFL ont une approche traditionnelle de l’analyse de données. Celle-ci n’a pas une seule couleur : l’analyse de données peut être « batch », c’est à dire massive et impliquant des temps de calcul de l’ordre de la semaine ; et elle peut être sous forme de « queries », pour lesquelles la réponse doit être apportée dans la milliseconde. Comme nous voulions que Big Foot soit capable d’absorber ces deux types d’analyse, et d’avoir ainsi une certaine interactivité avec les bases de données. C’est ce que nous a permis la collaboration avec l’EPFL.

TU Berlin nous a apporté sa spécialité sur les réseaux. Nous voulions fournir quelque chose qui n’existe pas dans les services commerciaux : une garantie sur les temps de réponse et le degré d’utilisation de la bande passante allouée aux calculs. Nous avons donc réfléchi avec eux au moyen de construire des réseaux virtuels capables d’accepter les clusters de calcul et de les optimiser.

Ce projet, aujourd’hui à maturité, a-t-il été mis à l’épreuve pour tester si les objectifs étaient remplis ?

PM : Les partenaires industriels ont été nos premiers applicateurs. Ils nous ont permis de réaliser des études de cas sur deux domaines différents, qui mettent à l’épreuve l’architecture de Big Foot de façons différentes. Symantec a pour sa part utilisé Big Foot pour optimiser ses algorithmes de machine learning dédiés à l’analyse et la compréhension des campagnes de spam. GridPocket est, quant à elle, une jeune start-up qui recueille et traite des données collectées par capteurs intelligents sur les consommations ponctuelles d’énergie. Dans ce cadre, Big Foot a aussi été utilisé pour le développement d’algorithmes de machine learning permettant la prévision de charge de consommation, la compréhension des utilisateurs et la modulation de l’offre énergétique selon la demande.

À présent que sa phase d’évaluation est terminée, quelles sont les perspectives pour Big Foot ?

PM : Actuellement, le projet est à 80 % open-source. Nous aimerions réussir à le mettre à 100 % open-source ; mais pour cela il faudra attendre qu’une des start-up créées à partir de DINoDB rende ce logiciel prêt aux environnements de production. Au-delà de cela, nous continuons de travailler sur plusieurs aspects. Un des thèmes très importants est la gestion des ressources dans les clusters de calcul. Nous avons ainsi commencé une recherche pour travailler sur les containers Linux permettant d’optimiser et de gérer ces ressources.

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !