Le partage de données, un enjeu collectif européen

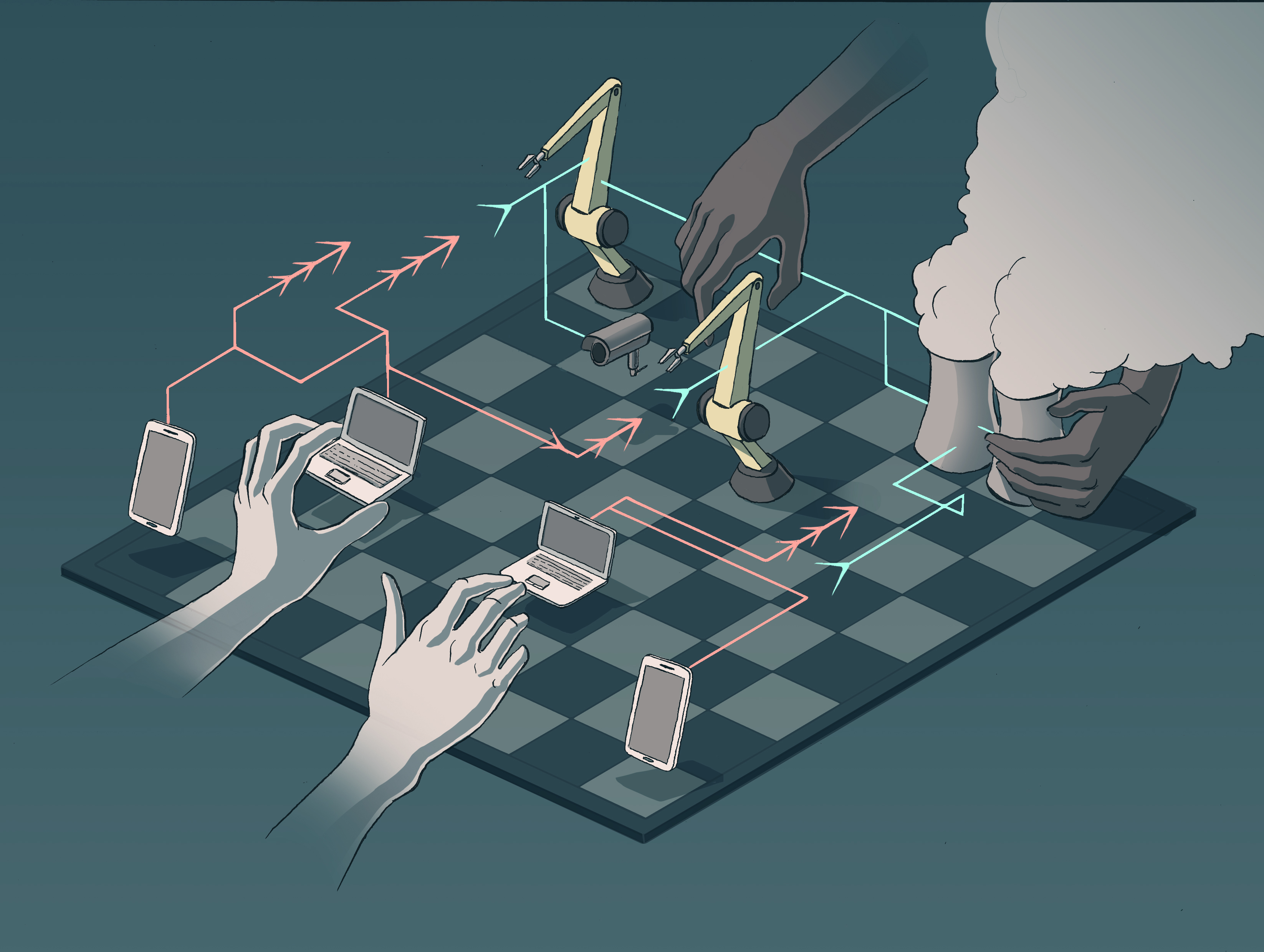

Favoriser le partage de données entre acteurs économiques est l’un des grands objectifs de l’Europe dans le cadre de sa stratégie de gouvernance numérique. Pour y parvenir, deux défis notables sont à relever. D’un côté, il faudra fédérer une communauté autour des enjeux de la donnée, rassemblant des acteurs de natures diverses et de secteurs multiples. D’un autre côté, il est nécessaire d’uniformiser les choix technologiques mis en place par ces acteurs.

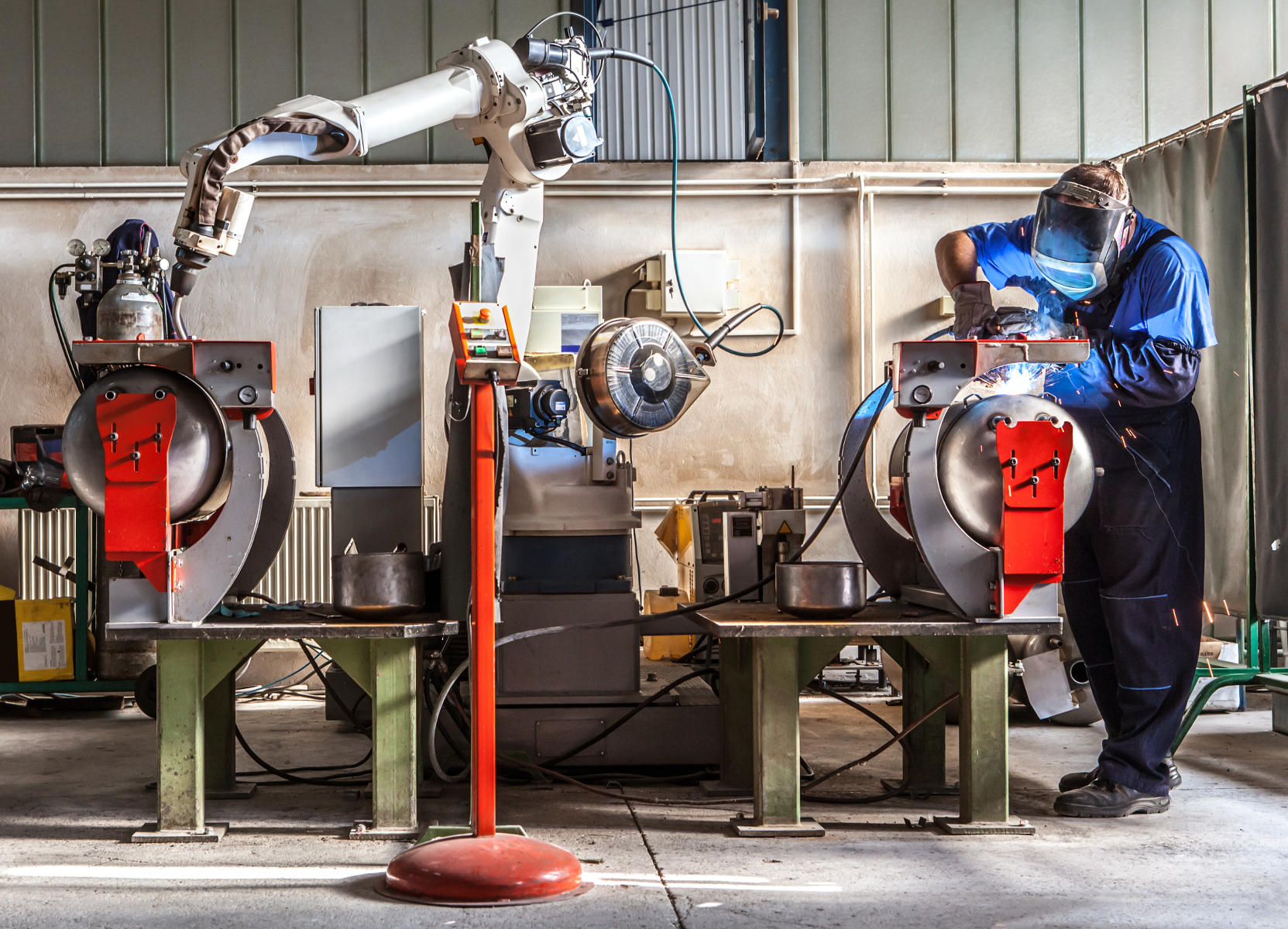

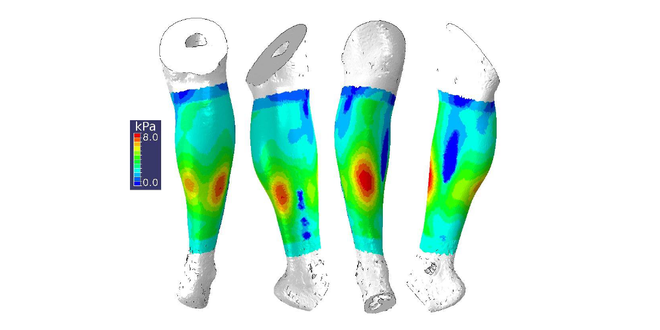

« Si nous voulons des algorithmes plus efficaces, avec une incertitude qualifiée, et des biais réduits, il nous faut non seulement plus de données, mais aussi des données plus diverses » problématise Sylvain Le Corff. Chercheur en statistiques à Télécom SudParis, il illustre là tout l’enjeu autour du partage de données. Et ce besoin n’est pas valable que pour les chercheurs. Les industriels aussi ont besoin de renforcer leurs données avec celles de leur écosystème. Ainsi un producteur d’énergie bénéficiera grandement d’un échange de données industrielles avec les distributeurs ou avec les associations de consommateurs, et inversement. Un constructeur automobile sera d’autant plus performant qu’il aura plus de sources de données de la part de ses sous-traitants.

Problème : ce partage n’est pas une opération triviale. En cause les nombreuses solutions techniques qui existent pour produire, stocker, et utiliser une donnée. Longtemps, l’idée dominante chez les acteurs économiques était de tenter d’exploiter soi-même ses données. Chaque organisation a donc fait des choix personnels quant aux architectures, aux formats, ou aux protocoles relatifs aux données. Or, un algorithme développé pour exploiter des jeux de données dans un certain format ne pourra pas utiliser des données conditionnées dans un autre. Il faut alors passer par une lourde étape d’uniformisation.

« Cet aspect technique est souvent sous-estimé dans les considérations de partage, remarque Sylvain Le Corff. Pourtant, nous nous rendons compte que l’opération de prétraitement pour harmoniser les données est une vraie difficulté. » Le chercheur prend ainsi l’exemple de l’analyse automatique du langage, une thématique importante de l’intelligence artificielle qui s’appuie sur le traitement automatique de textes provenant de sources multiples : textes bruts, textes générés à partir de documents audio ou vidéo, textes produits à partir d’autres textes, etc. On parle alors de multimodalité. « La pluralité des sources est bien gérée dans le domaine, mais en revanche la façon de gérer cette multimodalité peut changer au sein d’un même secteur. » Deux laboratoires, ou deux entreprises, ne vont donc pas harmoniser leurs données de la même façon. Pour travailler ensemble, il faudra alors absolument passer par ce fameux prétraitement fastidieux, qui peut être un frein à la collaboration.

Un standard européen de la donnée

Chercheur en intelligence artificielle et interopérabilité à Mines Saint-Étienne, Olivier Boissier ajoute un élément au problème : « Les personnes qui aident à produire ou traiter des données ne sont pas forcément experts de la donnée ou de l’IA. Ce sont généralement des personnes qui ont une expertise forte dans le domaine d’application, mais qui ne savent donc pas toujours comment ouvrir des jeux de données, ni comment les mutualiser. » Face à ces limitations techniques, une approche prometteuse consiste à standardiser les pratiques. Une tâche à laquelle s’attelle l’International Data Spaces association (IDSA), dont le rôle est de favoriser le partage de données à l’échelle globale, et notamment en Europe.

Contrairement à ce que l’on peut imaginer, l’idée d’un standard de la donnée n’est pas d’imposer une norme unique sur le format de données, l’architecture ou le protocole. Chaque domaine a déjà travaillé sur des ontologies permettant de faciliter un peu le dialogue entre jeux de données. « Nous ne voulons pas apporter une énième ontologie de domaine, précise Antoine Garnier, chef de projet à l’IDSA. Nous proposons plutôt un méta-modèle qui permet de décrire les jeux de données en s’appuyant justement sur ces ontologies de domaine, et de manière agnostique par rapport aux secteurs auxquels il s’adresse. »

Ce standard peut être vu en quelque sorte comme une liste de conditions sur laquelle se baser pour exploiter les données. « Les trois piliers sont l’interopérabilité, la certification, et la gouvernance des données », pointe Antoine Garnier pour résumer les conditions regroupées dans ce modèle d’architecture proposé par l’IDSA. Grâce à cette approche, le standard qui en découle sert de gage de qualité entre acteurs. Il permet de dire rapidement si une organisation remplit ces conditions, et est donc digne de confiance. Derrière ce système se joue bien évidemment la question de la sécurité, qui est l’une des premières préoccupations des organisations lorsqu’elles consentent à ouvrir leurs données.

L’Europe, région des grands lacs de données ?

Si mettre au point un standard est un pas en avant sur le plan technique, encore faut-il qu’il soit utilisé. Et pour cela, il est nécessaire que sa conception intègre les préoccupations techniques, juridiques, économiques, et politiques des acteurs européens de la donnée — producteurs comme utilisateurs. C’est là toute l’importance de la création d’une communauté rassemblant un maximum d’organisations. En Europe, depuis juin 2020, cette communauté a un nom : Gaia-X, une association d’acteurs rassemblant notamment l’IMT et l’IDSA pour structurer les efforts autour de la fédération de clouds pour la data, le logiciel et l’infrastructure. Au travers de Gaia-X, organisations publiques et privées ambitionnent de déployer des actions de standardisation — en s’appuyant notamment sur le standard de l’IDSA — mais également de recherche, de formation, ou encore de sensibilisation.

« La problématique est tellement vaste que si l’on veut la résoudre, il faut l’aborder par une communauté de spécialistes en sécurité, en interopérabilité, en gouvernance, en analyse de données », souligne Olivier Boissier pour montrer l’importance du dialogue entre experts sur le sujet. En parallèle de leur engagement dans Gaia-X, l’IMT et l’IDSA organisent ainsi une école d’hiver du 2 au 4 décembre pour sensibiliser des jeunes chercheurs aux enjeux du partage des données (voir encadré ci-dessous). Soutenue par l’Académie franco-allemande pour l’industrie du futur, elle doit donner des clés de compréhension des enjeux techniques et humains, au travers de cas concrets. « Au sein de la communauté de recherche, nous avons l’habitude de participer à des conférences pour nous tenir informés de l’état de l’art de notre thématique, mais il est difficile de s’ouvrir en profondeur aux problématiques d’autres disciplines », concède Sylvain Le Corff. « Ce type d’évènement franco-allemand est nécessaire pour structurer la communauté européenne, et s’approprier un sujet de manière globale, en prenant du recul par rapport à notre champ d’expertise. »

Pour la Commission européenne, l’ambition de créer un espace de libre circulation des données en Europe est assumée dans sa stratégie. Comprendre : un environnement commun et décentralisé où les données personnelles et confidentielles seraient sécurisées, mais où les organisations pourraient accéder facilement à une importante quantité de données industrielles dans le respect de la souveraineté de ceux qui les partagent. Pour atteindre ce tableau idyllique en matière de coopération entre acteurs de la donnée, la condition sine qua none est la participation des organisations au collectif. Pour les académiques, l’approche communautaire est au cœur de la pratique et ne représente pas un grand défi. Pour les entreprises en revanche, il faut encore en convaincre certaines. En majorité, les grands industriels ont compris les bénéfices du partage de données, « mais certaines entreprises sont encore dans l’idée que les données sont comme un trésor de guerre monétisable qu’il faut éviter de partager, témoigne Antoine Garnier. Il faut faire preuve de pédagogie et casser les idées reçues. »

À lire sur I’MTech : Le partage de données : un enjeu du secteur agricole

Et pour les acteurs non européens ? Lorsque l’on parle de partage de données, on parle mécaniquement du cloud, un marché trusté par trois acteurs américains : Amazon, Microsoft et Google, derrière lesquels on trouve d’autres acteurs américains (IBM, Oracle) et quelques acteurs chinois comme Alibaba et Tencent. Comment convaincre ces « hyperscalers » — le nom fait référence à leur capacité de monter en échelle pour satisfaire la demande grandissante, quel que soit le secteur — d’adopter un standard qui n’est pas le leur, alors même qu’ils sont propriétaires des technologies sur lesquelles reposent la majorité des utilisations des données ? « Paradoxalement, nous ne sommes peut-être pas une si mauvaise nouvelle pour eux, assure Antoine Garnier. Ce que nous proposons derrière ce standard, c’est aussi une forme de label. Cela leur permet d’afficher un respect des règles. »

Derrière cette stratégie de normalisation se joue la souveraineté numérique européenne et la diffusion de ses valeurs. De la même façon que l’Europe a réussi à imposer un standard sur la protection des données personnelles dans les années 2010 avec la concrétisation du RGPD, elle travaille maintenant à définir un standard autour du partage de données industrielles. Avec le même angle d’attaque : faire de la standardisation un gage de sécurité et de gestion responsable. « On voit souvent le standard comme une contrainte, mais c’est surtout une liberté, conclut Olivier Boissier. En l’adoptant, on se libère des contraintes techniques et juridiques spécifiques à chaque utilisation donnée. »

[box type= »info » align= » » class= » » width= » »]

Du 2 au 4 décembre : une école d’hiver sur le partage de données

L’IMT, au travers de la thématique phare Data Analytics & AI, et la TU Dormund organisent une école d’hiver sur le partage de données pour les systèmes industriels du 2 au 4 décembre 2020, avec l’aide de l’IDSA, de l’Académie franco-allemande pour l’industrie du futur, et le soutien de l’Université franco-allemande. Destinée aux doctorants et jeunes chercheurs, elle a pour but d’ouvrir les perspectives et de dresser un état de l’art sur la thématique de l’échange de données entre acteurs européens. Grâce à la participation de différents experts européens, cette école d’hiver abordera les enjeux techniques, économiques et éthiques du partage de données en croisant les expertises disciplinaires de chercheurs et d’industriels.

[/box]

Par Benjamin Vignard.

Trackbacks (rétroliens) & Pingbacks

[…] > Le partage de donnée, un enjeu collectif européen […]

[…] Lire l’article du blog recherche IMT […]

[…] Le partage de données, un enjeu collectif européen […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !